DeepSeek (языковая модель)

| программное обеспечение | |

| DeepSeek | |

|---|---|

| Тип | |

| Разработчик | |

| Языки интерфейса |

многоязычный, в том числе русский |

| Первый выпуск |

2 ноября 2023 (DeepSeek Coder) |

| Аппаратная платформа |

браузер, интерфейс программирования приложений, IOS и Android |

| Последняя версия |

(январь 2025 года) |

| Состояние |

функционирует |

| Лицензия | |

| Сайт | |

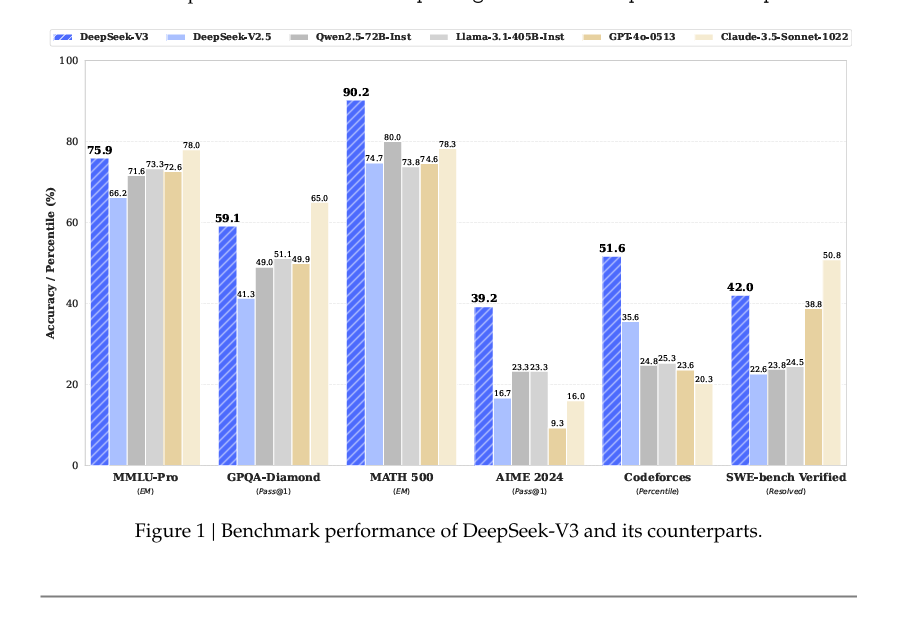

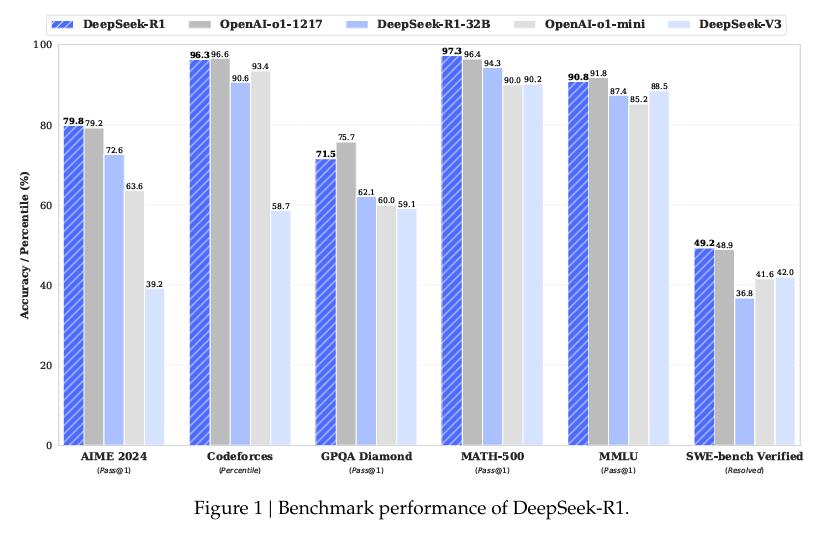

DeepSeek — семейство языковых моделей с открытым исходным кодом, разрабатываемое одноимённой китайской лабораторией искусственного интеллекта. Новейшие версии большой языковой модели с чат-ботом — DeepSeek-V3 и «думающая» DeepSeek-R1 для решения логических задач — демонстрируют равные или лучшие показатели в обработке естественных языков, математических задачах и программировании по сравнению с разработками конкурентов (GPT-4о или Open AI-o1 соответственно, а также аналогичные модели от других западных компаний)[1][2][3][4].

При этом, по утверждению DeepSeek, их модели требуют на порядок меньше ресурсов для обучения и поддержания работы, а также не ограничивают доступ для пользователей из России и любых других стран мира[2][5]. Кроме того, стоимость использования моделей в среднем на 96 % ниже, чем у западных конкурентов[6][7].

Выход на рынок модели DeepSeek-R1 20 января 2025 года вызвал масштабный обвал рыночных котировок технологических компаний США (как работающих в сфере искусственного интеллекта, так и производителей вычислительного оборудования), а также спровоцировал дискуссию об обоснованности многомиллиардных вложений в западную ИИ-инфраструктуру, завышенных требованиях к оборудованию и его стоимости[8][9].

История развития[править]

→ DeepSeek

DeepSeek был выделен в самостоятельный стартап из ИИ-направления китайского хедж-фонда High-Flyer, основанного в 2015 году китайским миллиардером и энтузиастом в сфере ИИ Ляном Вэньфаном. В июле 2024 года он заявлял об ограниченности современных генеративных моделей, а задачей новой компании обозначал достижение общего искусственного интеллекта (AGI)[10]. В ноябре 2024 года глава компании ещё раз подтвердил свою приверженность идее создания продуктов с открытым исходным кодом и отсутствии планов по какому-либо дальнейшему расширению платных услуг DeepSeek[11].

Условия распространения продуктов DeepSeek[править]

В отличие от ведущих западных компаний в области искусственного интеллекта (OpenAI, Meta или Anthropic) все языковые модели DeepSeek с самого начала распространялись под свободной лицензией MIT. Комментируя успех DeepSeek V3 и DeepSeek R-1 в январе 2025 года главный специалист Meta по искусственному интеллекту Ян Лекун заявил, что «в сфере ИИ модели с открытым исходным кодом доказали своё превосходство над проприетарными решениями»[12].

Релизы[править]

С ноября 2023 года DeepSeek представила 3 генерации больших языковых моделей.

DeepSeek Coder и DeepSeek LLM[править]

Первая нейросеть от DeepSeek Coder была представлена 2 ноября 2023 года. 29 ноября вышла первая универсальная большая языковая модель DeepSeek LLM с 67 млрд параметров, которая на тот момент превосходила возможности LLama 2 и приближалась к GPT-4[13], однако, по некоторым данным, имела проблемы с масштабируемостью и вычислительной эффективностью[13]. Тогда же был впервые представлен интеллектуальный чат-бот, работающий на основе DeepSeek LLM.

Всего было разработано 8 вариантов первой модели: четыре стандартных предобученных (Base) и четыре прошедших тонкую настройку набором инструкций (Instruct). Все они опирались на трансформерную архитектуру, использующую механизм «внимания», схожую с той что используют модели Llama.

- Предобучение проходило на 1,8 трлн токенов (в науке о данных 1 млн токенов приблизительно равняется 750 тыс. слов)[14].

- Long-context pretraining (LCP, с англ. — обучение работе с длинными контекстными последовательностями) базовых моделей проходило на 200 млрд токенов, что позволило нарастить максимальную длину обрабатываемого сетью контекста с 4 до 16 тыс. токенов.

- Тонкая настройка Instruct моделей проходила на основе наборов инструкций объёмом 2 млрд токенов[15].

DeepSeek-V2[править]

В мае 2024 года DeepSeek выпустила вторую версию языковой модели в четырёх вариантах: стандартная (V2), уменьшенная (V2-Lite), а также стандартный чат-бот (V2-Chat) и его уменьшенная версия (V2-Chat-Lite).

Количество параметров в старших моделях возросло до 236 млрд; предобучение проводилось на 8,1 трлн токенов, а максимальная длина контекста возросла до 128 тыс. токенов.

Модель претерпела значительные архитектурные изменения по сравнению с первой версией: в ней применён инновационный метод машинного обучения на основе низкоранговой аппроксимации Multi-head Learning Attention (MLA, с англ. — «Обучение со множественным вниманием»)[16], позволивший многократно уменьшить стоимость и время обучения модели[16][17]. Кроме того компания разработала и внедрила в модель доработанный принцип Mixture of Experts (MoE, с англ. — «смесь экспертов»): при таком подходе модель состоит из большого числа подсетей, каждая из которых отвечает за свою специализированную область знаний и подключается к поиску ответа только по необходимости[17][18].

Комбинация MLA и MoE позволила установить стоимость обработки миллиона токенов в 2 юаня, в то время как у ChatGPT она равнялась 2,5 долларам за аналогичный объём информации[19]. При этом DeepSeek-V2 демонстрировала конкурентоспособное качество работы: лаборатории искусственного интеллекта при университете Ватерлоо поместила на 7 место в рейтинге лучших больших языковых моделей[20].

DeepSeek-V3[править]

В декабре 2024 года в открытый доступ вышла третья генерация модели в двух вариантах: стандартная (V3-Base) и чат-бота (V3), содержащая 671 млрд параметров и проходившая обучение на 14,8 трлн токенов. Нейросеть, построенная на апробированной в DeepSeek-V2 архитектуре, способна анализировать и пересказывать тексты, выделяя главное, делать переводы, а также решать математические задачи и писать программы[2] на одном уровне с наиболее продвинутыми моделями от OpenAI, Meta или Anthropic: так DeepSeek-V3 превосходит в тестах Llama 3.1 Qwen 2.5[1] и соответствует уровню GPT-4о и Claude 3.5 Sonnet[2][3].

Представленное DeepSeek бесплатное приложение — чат-бот «DeepSeek — AI Assistant» — к концу января 2025 стало самым скачиваемым в мире, а также обошло ChatGPT в рейтинге самых высокооценённых бесплатных приложений в США[21]. Кроме того DeepSeek не поддерживает политику санкций и никак не ограничивает доступ к своей модели, предоставляя равные возможности для пользователей из всех стран мира — в том числе России[2].

При этом, по утверждению разработчиков модели, время её обучения составило всего лишь 55 дней на массиве из около 2000 урезанных для соблюдения требований экспортного контроля видеокарт Nvidia; таким образом стоимость обучения составила всего 5,5 млн долларов, как минимум на порядок раз ниже, чем Llama или GPT-4o[7][22].

В марте 2025 года DeepSeek выпустила обновление V3, получившее название V3-0324[23]. Сообщалось, что обновлённая версия продемонстрировав рекордные результаты в математике и программировании[24].

Особенности модели[править]

Таких показателей эффективности удалось добиться благодаря особенностям архитектуры DeepSeek:

- Метод Multi-token Prediction (MTP), позволяющий анализировать разные части предложения одновременно и предсказывать несколько слов одновременно, что повышает скорость работы модели и точность её ответов.

- Технология Mixture of Experts (MoE), которая внедряет в модель «экспертные» подсети, использующиеся для поиска нужного ответа на вопросы по специальным областям знаний. В DeepSeek-V3 встроено 256 таких нейросетей, из которых восемь активны постоянно, а остальные подключаются по необходимости для решения определённого вида задач.

- Внедрение подходы Multi-head Latent Attention (MLA) к настройке механизма внимания на основе низкоранговой аппроксимации привело к существенному уменьшению размеров и скорости работы структуры хранения пар «значение-ключ» (KV-cache), отвечающей за быстрый доступ к ранее вычисленной информации[25].

DeepSeek-R1[править]

20 января 2025 года DeepSeek представил свою думающую модель DeepSeek R1 для решения логических и математических задач с производительностью в математических тестах AIME и MATH на уровне флагманского решения Open AI-o1[4]. Отличительная особенность этой модели заключается в пошаговой генерации ответов, повторяющей процесс мышления у человека[26][27][28]. При её разработке компания использовала новый, более эффективный подход к моделированию вознаграждения при обучении с подкреплением[29].

Падение рынков в январе 2025 года[править]

Появление модели, которая требует многократно меньших затрат для обучения и использования, привела к обрушению котировок технологических компаний 28 января 2025 года. Так главный мировой поставщик оборудования для обучения нейросетей Nvidia потерял свыше 600 млрд долларов или почти 18 % капитализации, что стало крупнейшим обвалом в истории фондового рынка[30].

Существенные потери понесли практически все связанные с сектором ИИ компании — Nebius Аркадия Воложа (-4 %) Broadcom (-17,3 %), AMD (-8 %), Palantir (-7 %), Microsoft (-3 %), а также основные поставщики электроэнергии для дата-центров Constellation Energy (-21 %) и Vistra (-29 %). Индекс NASDAQ просел на 3,5 %, а S&P на 1,8 %. Суммарно же американские биржи потеряли более 1 трлн долларов[30], а стоимость криптовалют снизилась на 7 %[31].

Обвинение в краже технологий[править]

29 января 2025 года стало известно, что Microsoft и принадлежащая ей OpenAI начали расследование против DeepSeek. Компании утверждают, что китайский стартап несанкционированно обучал свои модели на данных, сгенерированных нейросетями OpenAI[32]. По версии американской корпорации, DeepSeek не является независимой разработкой, а создана методом дистилляции разработанных и запатентованных OpenAI моделей[33].

Санкции США как катализатор инноваций[править]

Известно, что для обучения моделей DeepSeek использовал закупленные ещё в 2021 году — то есть до введения США ограничений на поставки чипов в Китай — видеокарты Nvidia A100. По различным оценкам, в распоряжении стартапа DeepSeek находится около 10 тыс. штук таких видеокарт[7] (некоторые западные эксперты считают, что компания аккумулировала еще около 40 тыс. урезанных для соблюдения экспортных рестрикций видеокарт Nvidia H800[34][35]), в несколько раз меньше, чем у OpenAI или Llama (каждая компания имеет около 300 тыс. видеокарт)[36][19]. Таким образом, вероятно, ограниченные вычислительные мощности лишь подтолкнули DeepSeek к поиску перечисленных выше инновационных архитектурных решений, которые компенсировали этот недостаток[37].

Критика[править]

Дарио Амодей, создатель компании Anthropic, разрабатывающей большую серию языковых моделей Claude AI, считает, что китайские разработчики скорее громко заявили о себе, нежели добились выдающихся результатов. По мнению Амодея, DeepSeek создал модель, близкую к американским моделям 7-10 месячной давности, потратив на это меньше средств, но в рамках обычного тренда снижения затрат; плюс китайский стартап имел доступ к серьезным ресурсам. Амодей отметил, что DeepSeek показал хорошие результаты, но не стоит называть это революцией, так как снижение затрат соответствует обычному тренду, и общие затраты DeepSeek сопоставимы с расходами американских ИИ-лабораторий, Кроме того, DeepSeek-V3 более инновационна, чем нашумевший DeepSeek-R1[38].

Примечания[править]

- ↑ 1,0 1,1 Sharma, Shubham. DeepSeek-V3, ultra-large open-source AI, outperforms Llama and Qwen on launch (26 декабря 2024 года). Проверено 29 января 2025.

- ↑ 2,0 2,1 2,2 2,3 2,4 Нейросеть DeepSeek: что это, возможности, как пользоваться | РБК Тренды. Проверено 28 января 2025.

- ↑ 3,0 3,1 DeepSeek-V3: Китайская языковая модель превзошла Claude 3.5 Sonnet в работе с кодом. Проверено 28 января 2025.

- ↑ 4,0 4,1 DataSecrets Разбираемся, как устроена R1 – новая бесплатная ризонинг модель ИИ из Китая, работающая на уровне o1 от OpenAI. Habr.ru (21.01.2025).

- ↑ Разбираемся, как устроена R1 – новая бесплатная ризонинг модель ИИ из Китая, работающая на уровне o1 от OpenAI. Проверено 28 января 2025.

- ↑ DeepSeek R1: модель с производительностью o1 от OpenAI. Сравнение с o1, сколько стоит и как использовать API. Проверено 28 января 2025.

- ↑ 7,0 7,1 7,2 Запад шокирован китайским интеллектом (27 января 2025 года). Проверено 28 января 2025.

- ↑ «DeepSeek – это победа над сегрегацией человечества»: как китайцы хакнули ИИ-рынок рус.. БИЗНЕС Online. Проверено 28 января 2025.

- ↑ Китайская угроза (27 января 2025 года). Проверено 28 января 2025.

- ↑ 暗涌. 揭秘DeepSeek:一个更极致的中国技术理想主义故事. Проверено 30 января 2025.

- ↑ Schneider, Jordan. Deepseek: The Quiet Giant Leading China’s AI Race. Проверено 29 января 2025.

- ↑ Meta's chief AI scientist says DeepSeek's success shows that 'open source models are surpassing proprietary ones'. Проверено 28 января 2025.

- ↑ 13,0 13,1 Ksenia Se, Alyona Vert Topic 10: Inside DeepSeek Models. Turing Post (28.08.2024).

- ↑ Wiggers, Kyle. DeepSeek's new AI model appears to be one of the best 'open' challengers yet | TechCrunch (26 декабря 2024 года). Проверено 29 января 2025.

- ↑ Guo, Daya, Zhu, Qihao, Yang, Dejian, Xie, Zhenda, Dong, Kai, Zhang, Wentao, Chen, Guanting, Bi, Xiao, Wu, Y., Li, Y. K., Luo, Fuli, Xiong, Yingfei, Liang, Wenfeng DeepSeek-Coder: When the Large Language Model Meets Programming -- The Rise of Code Intelligence англ. // arXiv.org. — 2024-01-25.

- ↑ 16,0 16,1 DeepSeek — очередной квантовый скачок в развитии AI. Проверено 28 января 2025.

- ↑ 17,0 17,1 Dai, Damai, Deng, Chengqi, Zhao, Chenggang, Xu, R. X., Gao, Huazuo, Chen, Deli, Li, Jiashi, Zeng, Wangding, Yu, Xingkai, Wu, Y., Xie, Zhenda, Li, Y. K., Huang, Panpan, Luo, Fuli, Ruan, Chong, Sui, Zhifang, Liang, Wenfeng DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models англ. // arXiv.org. — 2024-01-11.

- ↑ Большие языковые модели в 2024 году: полное сравнение рус.. www.gptunnel.com. Проверено 29 января 2025.

- ↑ 19,0 19,1 DeepSeek вызвал истерику у Американских ИИ корпораций. Проверено 28 января 2025.

- ↑ The Chinese quant fund-turned-AI pioneer, Financial Times (июнь 2024 года).

- ↑ BFM.ru. Китайская модель ИИ DeepSeek стала лидером по скачиванию в США. Проверено 28 января 2025.

- ↑ DeepSeek-AI, Liu, Aixin, Feng, Bei, Xue, Bing, Wang, Bingxuan, Wu, Bochao, Lu, Chengda, Zhao, Chenggang, Deng, Chengqi, Zhang, Chenyu, Ruan и др. DeepSeek-V3 Technical Report англ. // arXiv.org. — 2024-12-27.

- ↑ DeepSeek обновила открытую модель V3, улучшив её навыки программирования (26 марта 2025 года). Проверено 26 марта 2025.

- ↑ DeepSeek представила улучшенную ИИ-модель DeepSeek-V3. Она превосходит Claude и GPT-4.5 в ряде задач (25 марта 2025 года). Проверено 26 марта 2025.

- ↑ Erdil, Ege. How has DeepSeek improved the Transformer architecture? (17 января 2025 года). Проверено 29 января 2025.

- ↑ Elizabeth Gibney China’s cheap, open AI model DeepSeek thrills scientists англ. // Nature. — 2025-01-23. — ISSN 1476-4687. — DOI:10.1038/d41586-025-00229-6

- ↑ Chowdhury, Hasan KI aus China: Überholt dieses Startup jetzt OpenAI? нем.. Business Insider (2025-01-25).

- ↑ Sharma, Shubham Open-source DeepSeek-R1 uses pure reinforcement learning to match OpenAI o1 — at 95% less cost (en-US). VentureBeat (2025-01-20).

- ↑ Moris DeepSeek, по сути взломал один из святых Граалей ИИ. Smart-Lab (27.01.2025).

- ↑ 30,0 30,1 ИИ-пузырь лопнул: стоимость Nvidia рухнула на $600 млрд за сутки из-за китайского стартапа DeepSeek. Проверено 29 января 2025.

- ↑ Рынок криптовалют упал на 7%. Причем тут ИИ-стартап из Китая DeepSeek на NFT.RU (27 января 2025 года). Проверено 29 января 2025.

- ↑ Microsoft и OpenAI расследуют, обучался ли DeepSeek на украденных данных американских компаний в сфере ИИ. Проверено 29 января 2025.

- ↑ BFM.ru. DeepSeek заподозрили в краже технологий OpenAI. Проверено 29 января 2025.

- ↑ Overclockers.ru: Одна только китайская компания DeepSeek имеет 50 000 санкционных чипов H100. Проверено 28 января 2025.

- ↑ Zafar, Ramish. Chinese AI Lab DeepSeek Has 50,000 NVIDIA H100 AI GPUs, Says AI CEO (25 января 2025 года). Проверено 30 января 2025.

- ↑ Times, GB. How many gpus does OpenAI have? - GB Times (30 сентября 2024 года). Проверено 28 января 2025.

- ↑ Kelsey Vlamis,Katherine Tangalakis-Lippert How the US may have unintentionally helped create an AI monster in China. AOL (28.01.2025).

- ↑ Dario Amodei Dario Amodei — On DeepSeek and Export Controls англ.. darioamodei.com. Проверено 30 января 2025.

↑ | |||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Концепции |

| ||||||||||||

| Модели |

| ||||||||||||

| Компании | |||||||||||||

Одним из источников, использованных при создании данной статьи, является статья из википроекта «Рувики» («ruwiki.ru») под названием «DeepSeek (языковая модель)», расположенная по адресу:

Материал указанной статьи полностью или частично использован в Циклопедии по лицензии CC-BY-SA 4.0 и более поздних версий. Всем участникам Рувики предлагается прочитать материал «Почему Циклопедия?». |